Zanim nauczymy się Backpropagation, zrozummy:

Co to są sztuczne sieci neuronowe?

Sieć neuronowa to grupa połączonych jednostek I/O, gdzie każde połączenie ma wagę związaną z jego programami komputerowymi. Pomaga ona w budowaniu modeli predykcyjnych z dużych baz danych. Model ten opiera się na ludzkim układzie nerwowym. Pomaga w prowadzeniu rozumienia obrazów, uczenia się ludzi, mowy komputerowej itp.

Co to jest wsteczna propagacja?

Wstępna propagacja jest istotą szkolenia sieci neuronowych. Jest to metoda precyzyjnego dostrajania wag sieci neuronowej na podstawie stopy błędu uzyskanej w poprzedniej epoce (iteracji). Odpowiednie dostrojenie wag pozwala na obniżenie poziomu błędów i uwiarygodnienie modelu poprzez zwiększenie jego generalizacji.

Backpropagacja to skrót od „wstecznej propagacji błędów”. Jest to standardowa metoda szkolenia sztucznych sieci neuronowych. Metoda ta pomaga obliczyć gradient funkcji straty w odniesieniu do wszystkich wag w sieci.

W tym poradniku dowiesz się:

- Co to jest sztuczna sieć neuronowa?

- Co to jest wsteczna propagacja?

- How Backpropagation Works

- Why We Need Backpropagation?

- Co to jest sieć typu Feed Forward?

- Typy Sieci Backpropagation

- Historia Backpropagation

- Kluczowe punkty Backpropagation

- Najlepsze praktyki Backpropagation

- Wady używania Backpropagation

Jak działa Backpropagation: Prosty Algorytm

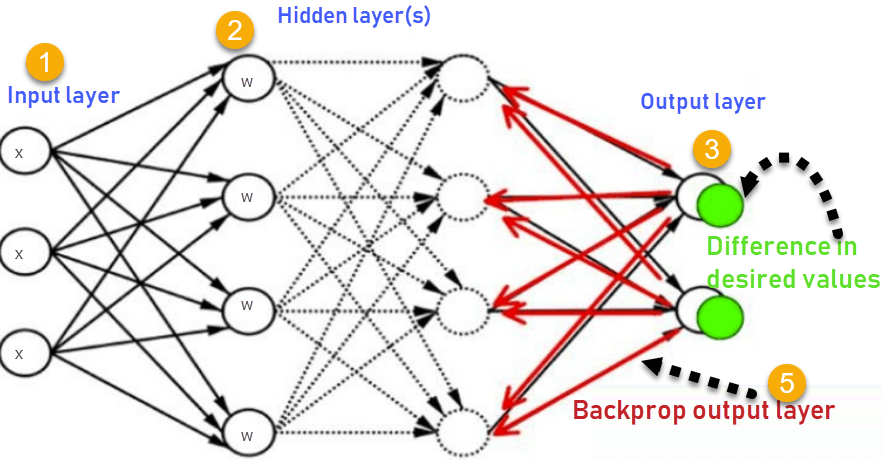

Rozważmy następujący schemat

- Wejścia X, docierają przez wstępnie połączoną ścieżkę

- Wejście jest modelowane za pomocą rzeczywistych wag W. Wagi te są zwykle wybierane losowo.

- Oblicz wyjście dla każdego neuronu od warstwy wejściowej, przez warstwy ukryte, do warstwy wyjściowej.

- Oblicz błąd na wyjściach

ErrorB= Actual Output – Desired Output

- Przejedź z powrotem z warstwy wyjściowej do warstwy ukrytej, aby dostosować wagi tak, aby błąd się zmniejszył.

Powtarzaj proces aż do osiągnięcia pożądanego wyniku

Dlaczego potrzebujemy wstecznej propagacji?

Najważniejsze zalety wstecznej propagacji to:

- Backpropagacja jest szybka, prosta i łatwa do zaprogramowania

- Nie posiada żadnych parametrów do dostrojenia poza liczbą wejść

- Jest to elastyczna metoda, ponieważ nie wymaga wcześniejszej wiedzy o sieci

- Jest to standardowa metoda, która generalnie działa dobrze

- Nie wymaga specjalnej wzmianki o cechach funkcji do nauczenia.

Co to jest sieć typu Feed Forward?

Sieć neuronowa typu feedforward jest sztuczną siecią neuronową, w której węzły nigdy nie tworzą cyklu. Ten rodzaj sieci neuronowej ma warstwę wejściową, warstwy ukryte i warstwę wyjściową. Jest to pierwszy i najprostszy typ sztucznej sieci neuronowej.

Rodzaje sieci wstecznej propagacji

Dwa rodzaje sieci wstecznej propagacji to:

- Statyczna wsteczna propagacja

- Recurrentna wsteczna propagacja

Statyczna wsteczna propagacja:

Jest to jeden rodzaj sieci wstecznej propagacji, która produkuje mapowanie statycznego wejścia dla statycznego wyjścia. Jest ona przydatna do rozwiązywania statycznych problemów klasyfikacyjnych, takich jak optyczne rozpoznawanie znaków.

Recurrent Backpropagation:

Recurrent backpropagation jest podawany do przodu aż do osiągnięcia ustalonej wartości. Po tym błąd jest obliczany i propagowany wstecz.

Główną różnicą pomiędzy obiema tymi metodami jest to, że odwzorowanie jest szybkie w statycznej propagacji wstecznej, podczas gdy w rekurencyjnej propagacji wstecznej jest ono niestatyczne.

Historia wstecznej propagacji

- W 1961 roku, podstawy koncepcji ciągłej wstecznej propagacji zostały wyprowadzone w kontekście teorii sterowania przez J. Kelly’ego, Henry’ego Arthura i E. Brysona.

- W 1969 roku Bryson i Ho podali metodę optymalizacji wieloetapowego systemu dynamicznego.

- W 1974 roku Werbos stwierdził możliwość zastosowania tej zasady w sztucznej sieci neuronowej.

- W 1982 roku Hopfield przedstawił swoją ideę sieci neuronowej.

- W 1986 roku, dzięki wysiłkom Davida E. Rumelharta, Geoffreya E. Hintona, Ronalda J. Williamsa, propagacja wsteczna zyskała uznanie.

- W 1993 roku Wan był pierwszą osobą, która wygrała międzynarodowy konkurs rozpoznawania wzorców za pomocą metody propagacji wstecznej.

Kluczowe punkty metody wstecznej propagacji

- Upraszcza strukturę sieci poprzez elementy ważone powiązań, które mają najmniejszy wpływ na trenowaną sieć

- Musisz zbadać grupę wartości wejściowych i aktywacji, aby opracować relacje między warstwami jednostek wejściowych i ukrytych.

- Pomaga to ocenić wpływ, jaki dana zmienna wejściowa ma na wyjście sieci. Wiedza uzyskana z tej analizy powinna być reprezentowana w regułach.

- Backpropagacja jest szczególnie przydatna w głębokich sieciach neuronowych pracujących nad projektami podatnymi na błędy, takimi jak rozpoznawanie obrazów czy mowy.

- Backpropagacja wykorzystuje łańcuch i reguły potęgowe, dzięki czemu backpropagacja może funkcjonować z dowolną liczbą wyjść.

Najlepsze praktyki Backpropagation

Backpropagation można wyjaśnić za pomocą analogii „Sznurowadła”

Zbyt małe napięcie =

.

- Niedostatecznie ograniczające i bardzo luźne

Zbyt duże napięcie =

- Zbyt duże ograniczenie (przetrenowanie)

- Zajmowanie zbyt wiele czasu (relatywnie powolny proces)

- Większe prawdopodobieństwo złamania

Ciągnięcie jednej koronki bardziej niż drugiej =

- Komfort (bias)

Wady używania Backpropagation

- Faktyczna wydajność backpropagation na konkretnym problemie zależy od danych wejściowych.

- Backpropagacja może być dość wrażliwa na zaszumione dane

- Musisz użyć podejścia opartego na macierzy dla backpropagacji zamiast mini-batch.

Podsumowanie

- Sieć neuronowa jest grupą połączonych jednostek wejścia/wyjścia, gdzie każde połączenie ma wagę związaną z jego programami komputerowymi.

- Backpropagacja jest krótką formą dla „wstecznej propagacji błędów”. Jest to standardowa metoda szkolenia sztucznych sieci neuronowych

- Backpropagation jest szybka, prosta i łatwa do zaprogramowania

- Sieć neuronowa typu feedforward jest sztuczną siecią neuronową.

- Dwa typy sieci wstecznej propagacji to 1)Statyczna wsteczna propagacja 2) Powtarzalna wsteczna propagacja

- W 1961 roku, podstawy koncepcji ciągłej wstecznej propagacji zostały wyprowadzone w kontekście teorii sterowania przez J. Kelly, Henry Arthur i E. Bryson.

- Backpropagacja upraszcza strukturę sieci poprzez usuwanie ważonych powiązań, które mają minimalny wpływ na trenowaną sieć.

- Jest szczególnie przydatna dla głębokich sieci neuronowych pracujących nad projektami podatnymi na błędy, takimi jak rozpoznawanie obrazów czy mowy.

- Największą wadą Backpropagation jest to, że może być wrażliwy dla hałaśliwych danych.