par Chris Woodford. Dernière mise à jour : 30 janvier 2020.

Avez-vous déjà entendu parler d’un ordinateur des années 1940 appelé l’ENIAC ? Il avait à peu près la même longueur et le même poids que trois ou quatre bus à deux étages et contenait 18 000 interrupteurs électroniques bourdonnants appelés tubes à vide.Malgré sa taille gargantuesque, il était des milliers de fois moins puissant qu’un ordinateur portable moderne – une machine environ 100 fois plus petite.

Si l’histoire de l’informatique ressemble à un tour de magie – faire rentrer de plus en plus de puissance dans de moins en moins d’espace – c’est le cas ! Ce qui l’a rendu possible, c’est l’invention du circuit intégré (CI) en 1958. Il s’agit d’un moyen ingénieux d’entasser des centaines, des milliers, des millions, voire des milliards de composants électroniques sur de minuscules puces de silicium pas plus grosses qu’un ongle. Regardons de plus près les circuits intégrés et leur fonctionnement !

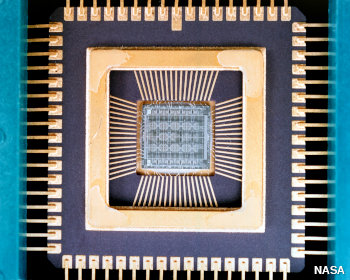

Photo : Un circuit intégré vu de l’extérieur. Celui-ci se présente sous une forme pratique appelée boîtier double ligne (DIP), qui consiste en un boîtier extérieur en plastique ou en céramique noir avec des broches métalliques en bas de chaque côté pour se brancher sur une carte de circuit électronique plus grande (la chose marron que vous pouvez voir en arrière-plan). Le circuit réel qui fait le travail est une toute petite puce intégrée à l’intérieur du DIP ; vous pouvez voir comment elle est connectée aux broches extérieures du DIP sur la photo suivante.

Qu’est-ce qu’un circuit intégré ?

Photo : Un circuit intégré vu de l’intérieur. Si vous pouviez soulever le couvercle d’une micropuce comme celle de la photo du haut (et vous ne pouvez pas le faire très facilement – croyez-moi, j’ai essayé !), voici ce que vous trouveriez à l’intérieur. Le circuit intégré est le petit carré au centre. Les connexions partent de ce carré vers les bornes (broches ou pattes métalliques) situées sur le pourtour. Lorsque vous branchez quelque chose à l’une de ces bornes, vous vous connectez en fait au circuit lui-même. Vous pouvez presque voir le motif des composants électroniques sur la surface de la puce elle-même. Photo reproduite avec l’aimable autorisation du Centre de recherche Glenn de la NASA (NASA-GRC).

Ouvrez un téléviseur ou une radio et vous verrez qu’ils sont construits autour d’un circuit imprimé (PCB) : un peu comme un plan de ville électrique avec de petits composants électroniques (tels que des résistances et des condensateurs) à la place des bâtiments et des connexions en cuivre imprimé les reliant entre eux comme des rues métalliques miniatures. Les circuits imprimés conviennent parfaitement à de petits appareils de ce type, mais si vous essayez d’utiliser la même technique pour construire une machine électronique complexe, comme un ordinateur, vous rencontrez rapidement un problème. Même l’ordinateur le plus simple a besoin de huit commutateurs électroniques pour stocker un seul octet (caractère) d’information. Donc, si vous voulez construire un ordinateur avec juste assez de mémoire pour stocker ce paragraphe, il vous faudra environ 750 caractères multipliés par 8, soit environ 6 000 commutateurs pour un seul paragraphe ! Si vous optez pour des commutateurs comme ceux de l’ENIAC – des tubes à vide de la taille d’un pouce adulte – vous vous retrouvez rapidement avec une énorme machine gourmande en énergie qui a besoin de sa propre mini-centrale électrique pour fonctionner.

Lorsque trois physiciens américains ont inventé les transistors en 1947, les choses se sont quelque peu améliorées. Les transistors étaient une fraction de la taille des tubes à vide et des relais (les interrupteurs électromagnétiques qui avaient commencé à remplacer les tubes à vide au milieu des années 1940), consommaient beaucoup moins d’énergie et étaient beaucoup plus fiables. Mais il restait le problème de relier tous ces transistors entre eux dans des circuits complexes. Même après l’invention des transistors, les ordinateurs restaient un enchevêtrement de fils.

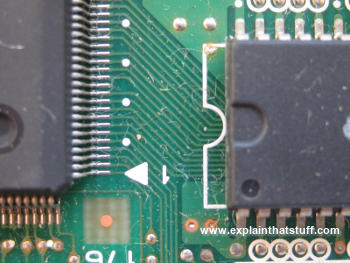

Photo : Les circuits intégrés s’insèrent dans des cartes de circuits imprimés (PCB) comme la carte verte que vous voyez ici. Remarquez les fines pistes qui relient les « jambes » (bornes) de deux circuits intégrés différents. D’autres pistes relient les circuits intégrés aux composants électroniques classiques tels que les résistances et les condensateurs. Vous pouvez considérer les pistes comme des « rues » reliant les « bâtiments » où sont effectuées des opérations utiles (les composants eux-mêmes). Il existe également une version miniaturisée d’un circuit imprimé à l’intérieur d’un circuit intégré : les pistes sont créées sous forme microscopique à la surface d’une plaquette de silicium.

Les circuits intégrés ont changé tout cela. L’idée de base était de prendre un circuit complet, avec tous ses nombreux composants et les connexions entre eux, et de recréer le tout sous une forme microscopique à la surface d’une pièce de silicium. C’était une idée incroyablement intelligente qui a rendu possibles toutes sortes de gadgets « microélectroniques » que nous tenons aujourd’hui pour acquis, des montres numériques et des calculatrices de poche aux fusées pour alunir et aux missiles avec navigation par satellite intégrée.

La loi de Moore

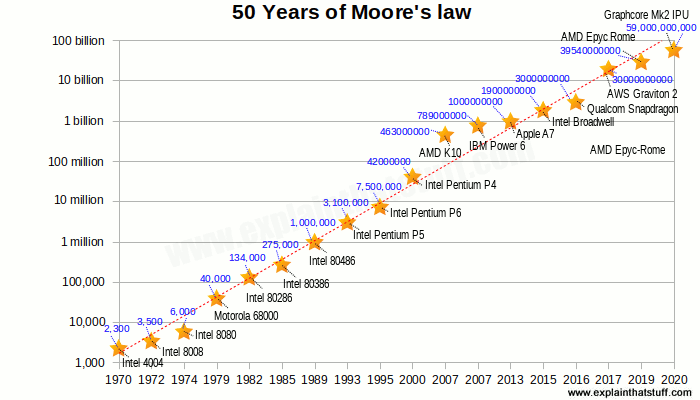

Les circuits intégrés ont révolutionné l’électronique et l’informatique au cours des années 1960 et 1970. D’abord, les ingénieurs mettaient des dizaines de composants sur une puce dans ce qu’on appelait l’intégration à petite échelle (SSI).L’intégration à moyenne échelle (MSI) a rapidement suivi, avec des centaines de composants dans une zone de la même taille.Comme on pouvait s’y attendre, vers 1970, l’intégration à grande échelle (LSI) a apporté des milliers de composants, l’intégration à très grande échelle (VLSI) nous a donné des dizaines de milliers, et l’intégration à ultra grande échelle (ULSI) des millions – et tout cela sur des puces pas plus grandes qu’avant. En 1965, Gordon Moore, de la société Intel, l’un des principaux fabricants de puces, a remarqué que le nombre de composants d’une puce doublait à peu près tous les un à deux ans. La loi de Moore, comme on l’appelle, n’a cessé de se vérifier depuis. Interviewé par le New York Times 50 ans plus tard, en 2015, Moore a révélé son étonnement de voir cette loi perdurer : « La prédiction initiale était de regarder sur 10 ans, ce qui me semblait exagéré. Il s’agissait de passer d’environ 60 éléments sur un circuit intégré à 60 000 – une extrapolation de mille fois plus sur 10 ans. Je pensais que c’était assez fou. Le fait que quelque chose de similaire se poursuive pendant 50 ans est vraiment étonnant. »

Chart : La loi de Moore : Le nombre de transistors emballés dans les micropuces a grossièrement doublé tous les ans ou tous les deux ans au cours des cinq dernières décennies – en d’autres termes, il a connu une croissance exponentielle. Si vous tracez le nombre de transistors (axe des y) en fonction de l’année de lancement (axe des x) pour certaines puces courantes des dernières décennies (étoiles jaunes), vous obtiendrez une courbe exponentielle ; si vous tracez le logarithme, vous obtiendrez cette ligne droite. Veuillez noter que l’axe vertical (y) de ce graphique est logarithmique et que (en raison du logiciel de graphisme OpenOffice que j’ai utilisé) l’axe horizontal (x) n’est que vaguement linéaire.Source : Tracé à l’aide de données provenant de Transistor Count, Wikipedia, vérifié par rapport à d’autres sources.